Descargo de responsabilidad

Esta publicación expresa la posición de su autor o del medio del que la recolectamos, sin que suponga que el Observatorio del Laicismo o Europa Laica compartan lo expresado en la misma. Europa Laica expresa sus posiciones a través de sus:

El Observatorio recoge toda la documentación que detecta relacionada con el laicismo, independientemente de la posición o puntos de vista que refleje. Es parte de nuestra labor observar todos los debates y lo que se defiende por las diferentes partes que intervengan en los mismos.

Cuando hablamos de inteligencia artificial (IA) debemos orientarnos con rigor a partir de las bases de las ciencias que la soportan. En otras palabras, nunca debemos apoyarnos en las expectativas generadas artificialmente alrededor de nuevos productos que nos intentan vender, así como en la tremenda hipérbole publicitaria (hype) que arrasa todos los medios. Las afirmaciones exageradas sobre sus éxitos dañan seriamente la reputación de la IA como ciencia y la pueden conducir a ser utilizada casi como una pseudociencia, al modo de la astrología, el terraplanismo y la homeopatía.

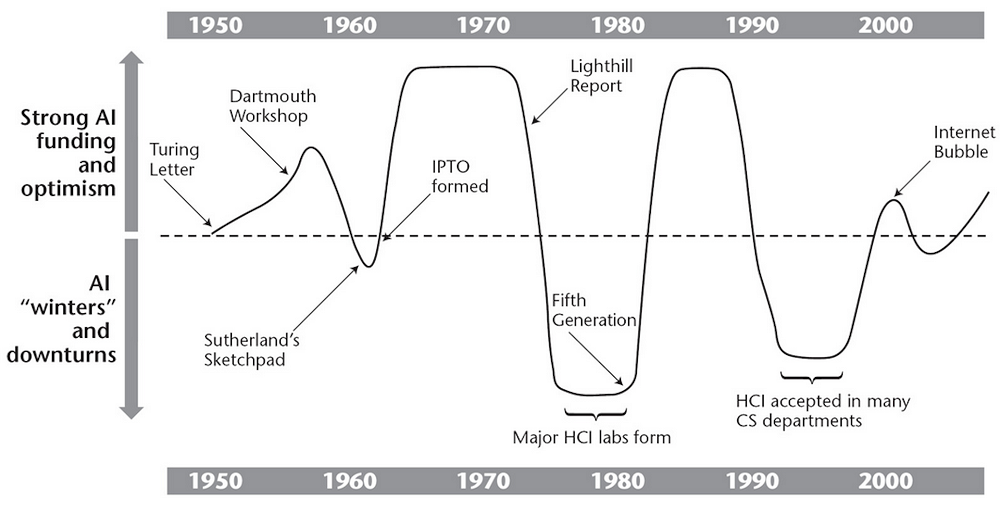

El científico Jonathan Grudin publicó en 2009 un artículo en el que ilustraba las bruscas oscilaciones del interés, financiación y avances reales de la IA a lo largo de su historia. En él se recurría a la metáfora de las estaciones del año, que nos permite comprender cómo ha evolucionado la IA desde su nacimiento.

Ahora, terminando el primer cuarto del siglo XXI nos encontramos en un período álgido, pero no son improbables futuras y profundas simas de inviernos de la IA, dado que aún hay mucho que investigar y comprender sobre esta importante área de conocimiento.

La comunidad científica de este campo es consciente de lo lejos que nos encontramos de modelar verdaderos sistemas nerviosos computacionales o de entender en qué consiste la inteligencia. Estos investigadores también asumen que no hay evidencia –ni matemática, ni física, ni biológica–, ni se conoce la existencia de ningún prototipo equivalente a las capacidades pensantes de un cerebro humano. Por ello aún es necesario gran esfuerzo en múltiples áreas si deseamos avanzar desde la ciencia y con pasos serios y firmes.

Las IA generativas son degenerativas

Los productos más populares de la industria IA en estos últimos tiempos son las “IA generativas” basadas principalmente en redes neuronales computacionales entrenadas con modelos de lenguaje de gran tamaño (LLM). Los ejemplos más conocidos son ChatGPT, MidJourney y Sora, capaces de generar texto, gráficos, sonido y vídeos.

Estas herramientas computacionales son entrenadas con enormes cantidades de datos presentes en internet, producidos por personas que tienen derechos legales de autoría de su material, pero que circula libre por la red.

Muchas empresas tienden a evitar demandas judiciales o a ahorrar costes y utilizan datos generados por sus propias IA para seguir entrenando sus máquinas. Desde las matemáticas se demuestra que este entrenamiento recursivo de la máquina con datos generados previamente por la propia máquina produce un efecto estadístico llamado “colapso del modelo”.

Este colapso da lugar a desinformación, degeneración de contenido, modelos de aprendizaje incorrectos crecientes, e incluso a un posible colapso de internet como fuente confiable.

Sabemos que muchas IA generan contenido con buena apariencia, pero falso. Si un buscador web se basa en una IA generativa como ChatGPT el resultado podría ser muy convincente, pero incorrecto. Si lo damos como válido y no lo comprobamos, y además liberamos ese contenido como entrenamiento para la IA, se llenaría de desinformación a una de nuestras fuentes más importantes de información.

Mala praxis en la industria IA

El negocio IA no se para, aunque la ciencia demuestre que no existe la IA fuerte o general (AGI) y que las herramientas particulares existentes (IA débil) necesitan mejoras significativas para asistir correctamente en la resolución de algunos problemas.

Muchas empresas tecnológicas continúan amplificando el hype para seguir haciendo crecer sus resultados económicos. Por poner unos pocos ejemplos de importantes empresarios del sector que saben que no es posible lo que dicen, podemos citar recientes declaraciones o “predicciones” de Elon Musk y de Mark Zuckerberg, quienes anuncian la inminente introducción de esta inexistente inteligencia artificial general en sus productos.

Una praxis quizás aún más censurable es la fundación por parte de Sam Altman (CEO de OpenAI, creadora de ChatGPT) de la empresa Worldcoin, dedicada a las criptomonedas. Muy llamativa ha sido su campaña en todo el mundo de capturar datos biométricos de personas (mayores o menores de edad) por medio de unos “orbes”, dispositivos atractivos para la juventud, que escanean el iris. La clientela capturada por medio de esta campaña cede sus datos a cambio de un token (un vale digital).

La justificación de Worldcoin es intentar ofrecer, en el futuro, una renta universal en criptomonedas para compensar la pérdida de empleos debido al avance de la IA. Afortunadamente, esta declaración tan burda ha permitido a varios países prohibir su actuación, pero muchos han sido captados ya por la empresa.

El culto de la singularidad

El conocido ingeniero e inventor Ray Kurzweil, autor de muchos libros sobre la IA, las máquinas espirituales y el transhumanismo, escribió en 2005 un gran éxito editorial titulado La singularidad está cerca.

La “singularidad tecnológica” es un hipotético acontecimiento por el que las máquinas superarán en inteligencia a la humanidad.

El argumento de Kurzweil se basa en una idea simplista que denominó “ley de los rendimientos acelerados”, en la que postula que el crecimiento científico y tecnológico es exponencial, como una versión generalizada de la ley de Moore de la industria informática.

Relevantes miembros de la industria y ciencia de la computación, como el propio Gordon Moore (cofundador de Intel) y Paul Allen (cofundador de Microsoft) y Mark Greaves expresaron desde hace muchos años una frontal disconformidad con la predicción de la singularidad. Uno de los motivos es que la neurociencia no funciona como los computadores y que ni siquiera hemos empezado a desvelar las capas de complejidad que nos impiden entender cómo funciona nuestra propia mente.

Kurzweil fundó en 2008 la Universidad de la Singularidad, con sede en California, para “reunir, educar e inspirar a un grupo de dirigentes”. Su libro principal, escrito usando términos científicos, pero dogmático y sin expresar ningún tipo de dudas en sus afirmaciones o profecías, es más bien un texto de fe en su transhumanismo. La Universidad de la Singularidad se parece mucho a otros cultos como la cienciología que han ido surgiendo en el último siglo.

Kurzweil pondrá a la venta en verano de 2024 su nueva secuela: The Singularity Is Nearer“, que seguramente se convertirá en un superventas. Anuncia que trata de expandir su universidad con nuevas sedes en Tel Aviv y Sevilla.

El nuevo texto de Kurzweil predice el advenimiento de la singularidad para 2029. Mientras la comunidad científica trata de avanzar en el conocimiento, el negocio de la IA no duda en sembrar la confusión, vender lo que sea y transformar esta ciencia en una peligrosa pseudociencia.

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

Este artículo fue publicado originalmente en The Conversation. Artículo original.